|

|

|

Datenschutz und Digitalpolitik in krisenhaften Zeiten

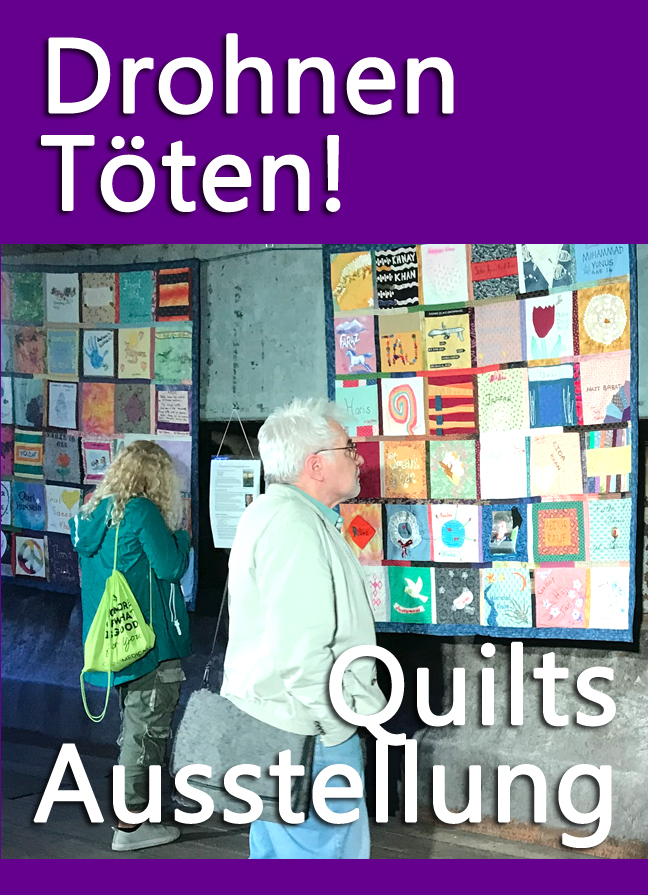

Am 1. und 2. Oktober waren wir bei der 10. Interdisziplinäre Jahrestagung der Plattform Privatheit im Fraunhofer Forum Berlin am Hackeschen Markt. Seit vielen Jahren nehmen Aktive unseres Vereins an dieser stets sehr interessanten Tagung teil. Die Projektpartner berichten dabei über ihre Fortschritte. Diese neuen Erkenntnisse kommen nicht nur aus der Informatik, sondern aus ganz verschiedenen Disziplinen. Die Vorträge werden demnächst auf deren Webseiten dargestellt, deshalb werden wir hier keine Inhaltsangabe machen, sondern nur die Projekte erwähnen, an deren Vorstellung wir teilnehmen konnten. Und dann werden wir auch nur die Punkte erwähnen, die uns aufgefallen sind. Prof. Dr. Alexander Roßnagel eröffnet die Konferenz und nannte die hauptsächlichen Probleme der deutschen Datenschützer im letzten Jahr:

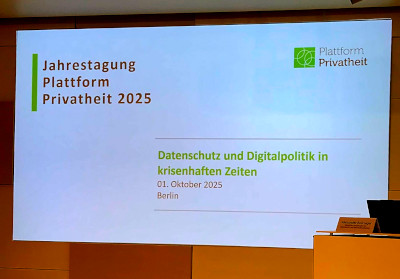

Alexandra-Gwyn Paetz, die Vertreterin des Bundesministerium für Forschung, Technologie und Raumfahrt (BMFTR) betonte, dass der Besitz von Daten immer mit Macht einher geht. ElizaDer italienische Datenschützer Guido Scorza (Garante per la protezione dei dati personali, Rom) der in Italien vor zwei Jahren ein Verbot von ChatGPT durchgesetzt hatte begann seinen Vortrag "Eliza's lesson (which we didn't learn) - Reflections on sentimental chatbots and major threats to data protection and digital policy" mit einem Hinweis auf das von Weizenbaum vor 59 Jahren in Betrieb genommene Programm Eliza. Mit diesem Programm konnte man schon damals (Text-basiert) sprechen.

Auch wenn dies wesentlich primitiver ablief, so entsprach die Funktion den heutigen KI Themen. Weizenbaum hatte Eliza nach vielen Tests selbst eingestampft. Auch für Scorza ist künstliche Intelligenz pandemisch, wobei er diesen Begriff nicht negativ besetzt sehen will sondern als Herausforderung. Die heutigen Probleme mit KI-Themen sieht er wie einen Eisberg, von dem nur 10% sichtbar sind. Alles andere bleibt für uns unter der Oberfläche. Als gefährliche Beispiele nannte er zum Beispiel, dass inzwischen 90% der Jobs durch eine Entscheidung von KI vergeben werden. Die Situationen aus dem Film Minority Report, der im Jahr 2054 spielen sollte, sind für Ihn bereits heute gegeben. Unterhaltung Musik, Fernsehen Kultur all diese Nutzung wird heute von Kl vorgeschlagen. Nutzen dies heute 40% der Menschen so werden im Jahr 2050 70% das kaufen, was ihnen die KI vorschlägt. Dies gilt gefährlicherweise auch für politische Meinungen. Letzteres beunruhigt ihn insbesondere, da eine politische Meinungsbildung ohne eine Unterscheidung zwischen wahr und falsch nur katastrophal enden kann. Seine Vorschläge sind: Bildung und Regulierung, denn in dem anderen Fall werden wir in einer Algocrazie statt Demokratie aufwachen. Außerdem müssen wir die Entwicklungsgeschwindigkeit reduzieren. 1865 trat nur zwei Jahre nach den ersten Automobilen ein Kraftfahrzeuggesetz in Großbritannien in Kraft, welches eine Geschwindigkeitsbegrenzung von 3,2 km/h vorschrieb und einen Begleiter des Fahrzeugs, der mit einer roten Fahne davor her zu laufen hatte. Im weiteren Verlauf sehen wir, dass in der Industrie die Entwicklung immer schneller abgelaufen ist. Als Beispiel nennt er die Telefonie, das Internet, Handy oder jetzt die künstliche Intelligenz. Während für eine Waschmaschine in den sechziger oder siebziger Jahren noch ein dickes Handbuch beilag, lässt man die Menschen heute auf ein Smartphone los ohne ihnen den Gebrauch oder erst recht nicht die Gefahren zu erläutern. Zum Punkt Bildung sagt er abschließend: Love your Rights Konversationelle KI-Agenten: Gegenwärtige und zukünftige HerausforderungenLisa Mühl (Universität Duisburg-Essen) beschäftigt sich mit Konversationellen Agenten, also mit der Beziehungen zwischen Menschen und künstlicher Intelligenz. Probleme sind dabei, dass sich die Menschen sobald sie eine emotionale Beziehung zu der künstlichen Intelligenz aufgebaut haben selbst offenbaren - und damit ihre Daten selbst anbieten. So eine Beziehung kann sehr eng werden und "stirbt" dann nach einem Update die "Beziehungsperson" weil sich die KI plötzlich anders verhält, so kann dies für den/die NutzerIn schwer werden. Jessica Heesen (Universität Tübingen) stellt dazu fest: Wahrhaftigkeit einer KI gibt es nicht, sondern meist Lob, schmeicheln, positive Verstärkung.Echte Kritik wird durch scheinbare Menschlichkeit verkleistert. Sie verweist auf Shoshana Zuboff, die das Ziel dieser Entwicklung so benennt: den Menschen als kostenloses Rohmaterial für den Überwachungskapitalismus zu formen. KennzeichnungKlar ist, dass Art. 50 des AI Act, die "Kennzeichnung" eines KI Inhalts nicht ausreicht. Fazit: neben den Problemen der eindeutigen Kennzeichnung kommt hinzu, dass die künstliche Intelligenz in die Medien und die Kunstfreiheit und in den Jugendschutz hinein reicht, da es nicht nur eine Darstellung erzeugt, sondern die Menschen sich mit dem System rückkoppeln. Dies kann bis zu pathologischen Beziehungen führen, die man vor der Existenz von KI auch in einigen Fällen zu seinem Auto oder seinem Haustier aufbauen konnte. Bei einer Abwägung zwischen Schaden und Nutzen der künstlichen Intelligenz muss man immer betrachten, dass unter der Oberfläche unsere persönlichen Daten an Fremde abfließen, ohne dass wir darauf einen Einfluss haben. Gibt es das menschliche in der künstlichen Intelligenz?ChatGPT erzählt unter Umständen auch von seinen Eltern. Real hat eine KI kein Innenleben sondern nur unendlich viel Wissen (zumindest im Vergleich zu der Person vor dem Gerät). Diese Unendlichkeit kann man sogar messen. Das System Reddit bietet eine Diskussionsplattform unter dem Namen "Change my View" an. Dort können Menschen eine Ansicht von Anderen kritisieren oder versuchen diese zu widerlegen oder zu bestätigen. Messungen haben ergeben, dass das Ergebnis der Überzeugungsarbeit etwa sechs mal besser ist, wenn eine künstliche Intelligenz argumentiert. ChatkontrolleDurch die beiden Vorträge zu dem Thema

... wurden unsere Befürchtungen weitgehend bestätigt. Wir haben bereits unzählige Artikel zu dem Thema auf unseren Webseiten. Am 14. Oktober soll auf EU-Ebene dazu eine Entscheidung gefällt werden. Dann werden wir sehen, ob Jede/r von uns künftig mit einem Staatstrojaner auf seinen Geräten rechnen muss. IoT

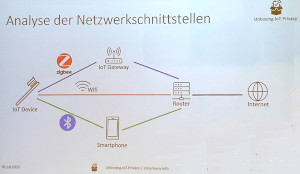

Privatsheits-relevante Eigenschaften von IoT-Produkten für Verbraucher:innen (Florian Dehling, Sebastian Koch, Luigi LoIacono, Lindrit Kqiku, Delphine Reinhardt und Harald Zwingelberg) Herr Dehling beschäftigt sich mit dem Internet of Things und der Frage welche Einflüsse es auf unsere Privatsphäre hat, wenn wir eine Kaufentscheidung treffen wollen. In dem Projekt wurden 53 Problembereiche identifiziert und versucht automatische Tools zu entwickeln, die einerseits den Daten Abfluss im Netzwerk automatisch kontrollieren können aber auch die zu den Produkten angehängte Datenschutzerklärung automatisch analysieren können. Smart Home ohne ZustimmungSmart Home ohne Zustimmung – Herausforderungen und Handlungsempfehlungen (Franziska Baum, Andreas Bischof und Tanja Lehmann) Frau Baum erweitert dieses auf die Gefahren innerhalb des Haushalts bei der Nutzung von Smart Home-Produkten. Einer kauft aber alle sind davon betroffen. Das Fazit ist, dass Frauen Kinder und Rentner meist die unfreiwillig Betroffenen sind. Sie werden durch ihren Partner oder durch Dritte überwacht. Private Räume sind keine sicheren Räume mehr. Kennzeichnungspflichten für synthetische MedieninhalteRechtliche Anforderungen und technische Realität (Moritz Griesel und Hans Brorsen) Herr Griesel beschäftigt sich mit der Art der Kennzeichnung von KI Inhalten. Der KI-Act schreibt in Art. 50 Abs. 2.51 vor, dass die Kennzeichnung maschinenlesbar sein muss. Nebenbemerkung: nur damit lässt sich der "Kollaps" verhindern. (Den Kollaps haben wir bisher immer mit dem dümmer werden des Internets bezeichnet). Die Kennzeichnung ist darüber hinaus wichtig um rechtswidrige Inhalte oder die Manipulation demokratischer Prozesse einzudämmen. Die Kennzeichnung verhindert jedoch den Schaden nicht. 98% der Deep Fakes sind pornographische Inhalte. In dem Projekt arbeitet eine Firma mit dem Tool Lumid, das zum Beispiel auch als Addon für den Browser entwickelt wurde. Dieses kann Bilder als KI-generiert identifizieren und kennt in seiner Datenbank bereits eine Vielzahl von Bildern und kann deren Quellen referenzieren.Gestaltungsspielräume kooperativer Nachrichtenplattformen... vor dem Hintergrund der Plattformisierung von Medienstrukturen (Markus Uhlmann, Pascal Altenkamp und Eva Hoffmeister). Herr Uhlmann stellt kooperative Plattformen als Alternative gegenüber den großen Internet Tech Konzernen vor. Bisher ist es so, dass viele Medienkonzerne ihre Produkte hinter einer Paywall verbergen (müssen). Damit verlieren Sie Reichweite. Um diese wieder zu erlangen, verkaufen Sie sich an Google News, wo diese Artikel ohne PayPal sichtbar werden (aber mit Werbung angezeigt werden). Um dem entgegen zu wirken, sollen kooperative Plattformen in Form von genossenschaftlichen Kooperationen sich gegenseitig unterstützen. Dies wird in einem EU Projekt gefördert, zum Beispiel in dem KI Übersetzungen in 20 europäische Sprachen auf dieser Plattform angeboten werden. Demokratie im KI-Zeitalter: Zwischen Inklusion und ManipulationKatja Muñoz (Deutsche Gesellschaft für Auswärtige Politik) vergleicht die Manipulation durch KI Systeme in verschiedenen Ländern, z.B. Deutschland, Frankreich, USA, Indien, Mexiko, Südafrika. Sie stellt fest, dass in den USA und in Indien die Manipulation stark personalisiert vorgenommen wird. So hat der Avatar des Gouverneurs eines US Bundesstaats bei der letzten Wahl 300.000 seiner Wähler ganz personalisiert angesprochen. In Indien besteht das Problem, dass es mindestens zehn wichtige Sprachen im Land gibt. Die künstliche Intelligenz übersetzt Videos oder Ansprachen in den Stimmen und mit der Mimik der Sprecher. Effektiver DatenschutzMeike Kamp (Berliner Beauftragte für Datenschutz und Informationsfreiheit) spricht darüber aus ihrer Perspektive als Aufsichtsbehörde. Sie erwähnt den Gegensatz zwischen dem Data Act und der DSGVO. Der Data Act soll der Industrie die Möglichkeit geben anonymisierte Daten für ihre Zwecke zu nutzen. Problematisch ist dies, weil auch nicht personalisierte Daten durch Anreicherung mit anderen Informationen wieder zu personenbezogenen Daten werden können. Die DSGVO verlangt eine Minimierung, der Data Act und die Systeme der künstlichen Intelligenz verlangen dagegen nach möglichst vielen Daten. Fragen die sich daraus ergeben: Es ist ein Trugschluss, wenn Unternehmen aus dem Data Act herauslesen, dass die DSGVO damit Schnee von gestern wäre. Im Data Act steht ganz klar: Die Vorschriften der DSGVO bleiben unberührt. Was uns sonst noch auffiel

SoPrivAdo - Vernetzung und Sicherheit digitaler Systeme - Im Rahmen des Projekts "SoPrivAdo" werden Bildungsmaterialien und ein Serious Game entwickelt, das Wissen auf eine spielerische Art vermittelt. Wir werden das Spiel künftig auch mit den Besuchern unserer Veranstaltung spielen können. Mehr dazu bei https://plattform-privatheit.de/p-prv/jahreskonferenzen/jahreskonferenz-2025.php Kommentar: RE: 20251005 Plattform Privatheit 25 "Nutzen dies heute 40% der Menschen so werden im Jahr 2050 70% das kaufen, was ihnen die KI vorschlägt." Be., 05.10.25 11:39 Kommentar: RE: 20251005 Plattform Privatheit 25 ich hab mal meinen Profiltext per OpenAI schreiben lassen - hat sich kaum unterschieden von den anderen Profiltexten mit all dem Achtsamkeits-Blabla An., 05.10.25 11:50 Kommentar: RE: 20251005 Plattform Privatheit 25 Meine Meinung zum Thema KI Ho., 07.10.25 11:15 Kategorie[26]: Verbraucher- & ArbeitnehmerInnen-Datenschutz Short-Link dieser Seite: a-fsa.de/d/3KE Link zu dieser Seite: https://www.a-fsa.de/de/articles/9302-20251005-plattform-privatheit-25.html Link im Tor-Netzwerk: http://a6pdp5vmmw4zm5tifrc3qo2pyz7mvnk4zzimpesnckvzinubzmioddad.onion/de/articles/9302-20251005-plattform-privatheit-25.html Tags: #AI #KI #LLMs #PlattformPrivatheit #Lauschangriff #Überwachung #Vorratsdatenspeicherung #Videoüberwachung #Rasterfahndung #Verbraucherdatenschutz #Datensicherheit #Informationsfreiheit #Anonymisierung #Meinungsfreiheit #Pressefreiheit #Diskriminierung #Ungleichbehandlung Erstellt: 2025-10-05 09:20:51 Aufrufe: 1114 Kommentar abgeben |

CC Lizenz Mitglied im European Civil Liberties Network Bundesfreiwilligendienst Wir speichern nicht World Beyond War Kein Java Transparenz in der Zivilgesellschaft

|

|

|

|

|

|

|

|

|